kafka 如何实现死信队列

Kafka本身并没有直接提供死信队列(Dead Letter Queue, DLQ)这一概念,这是源于消息中间件如RabbitMQ的一个特性。但在Kafka中,可以通过一些设计模式和实践来模拟实现死信队列的功能,以处理无法正常消费的消息。

Kafka中模拟死信队列的原理:

手动处理异常消息: 当消费者从Kafka主题中拉取消息消费时,如果遇到无法处理的消息,可以选择不提交偏移量(不确认消息),并将此消息标记为失败或错误消息。然后,消费者可以将这些消息发送到一个专门的“死信主题”(DLT,Dead Letter Topic)中,这个主题就可以被视为死信队列。

使用重试逻辑: 在消费者端,可以实现重试逻辑,当消息消费失败时,不是立即放弃,而是将消息重新放入队列尾部,等待下一次尝试。同时,可以设置重试次数限制,当达到预设的重试次数后,再将消息发送到死信主题。

TTL与消息到期: Kafka支持配置消息的生存时间(Time To Live, TTL)。当消息在队列中停留时间超过这个阈值后,Kafka会将消息移到一个特殊的主题,这个主题可以被视作是TTL到期后的死信队列。

使用Kafka Streams或Connectors: Kafka Streams或Kafka Connect可以用来实现更复杂的流处理逻辑,包括检测和处理失败消息,然后将这些消息重定向到死信主题。

事务和幂等性: 在某些情况下,为了保证消息不被重复处理或丢失,可以利用Kafka的事务特性来确保消息要么全部成功处理,要么全部不处理。当事务提交失败时,可以根据需要将消息发往死信队列。

实现注意事项:

消息格式: 发送到死信队列的消息可能需要携带额外的元数据,比如失败原因、原始主题、重试次数等,以便于后续分析和处理。

监控与告警: 对死信队列应该有相应的监控和告警机制,一旦有消息流入,应立即通知相关人员或系统,以便及时介入处理。

死信处理策略: 需要有一个明确的死信处理流程,可能是人工介入修正、自动修复后重新投递、或是记录日志后废弃等。

综上所述,虽然Kafka没有直接内置死信队列功能,但通过上述方法可以在实际应用中实现类似的功能,从而保证消息处理的健壮性和故障隔离。

原文链接: https://www.yukx.com/kafkamq/article/details/2521.html 优科学习网kafka 如何实现死信队列

-

Kafka中的Rebalance称之为再均衡,是Kafka中确保Consumergroup下所有的consumer如何达成一致,分配订阅的topic的每个分区的机制。Rebalance触发的时机有:1.消费者组中consumer的个数发生变化例如:有新的consumer加入到消费者组,或者是某个co

Kafka中的Rebalance称之为再均衡,是Kafka中确保Consumergroup下所有的consumer如何达成一致,分配订阅的topic的每个分区的机制。Rebalance触发的时机有:1.消费者组中consumer的个数发生变化例如:有新的consumer加入到消费者组,或者是某个co -

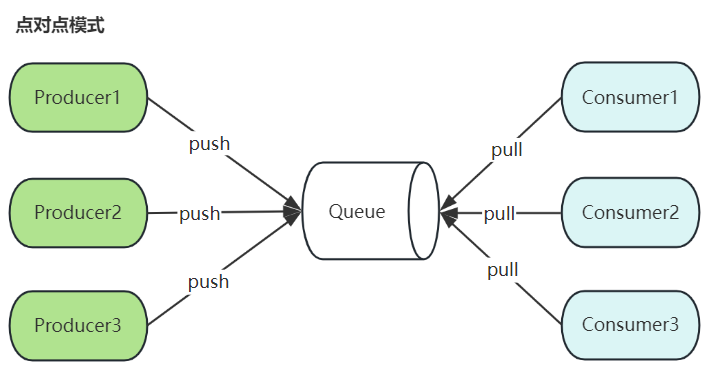

一、Kafka简介Kafka是最初由Linkedin公司开发,是一个分布式、支持分区的(partition)、多副本的(replica),基于zookeeper协调的分布式消息系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景:比如基于hadoop的批处理系统、低延迟的实时系统、sto

一、Kafka简介Kafka是最初由Linkedin公司开发,是一个分布式、支持分区的(partition)、多副本的(replica),基于zookeeper协调的分布式消息系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景:比如基于hadoop的批处理系统、低延迟的实时系统、sto -

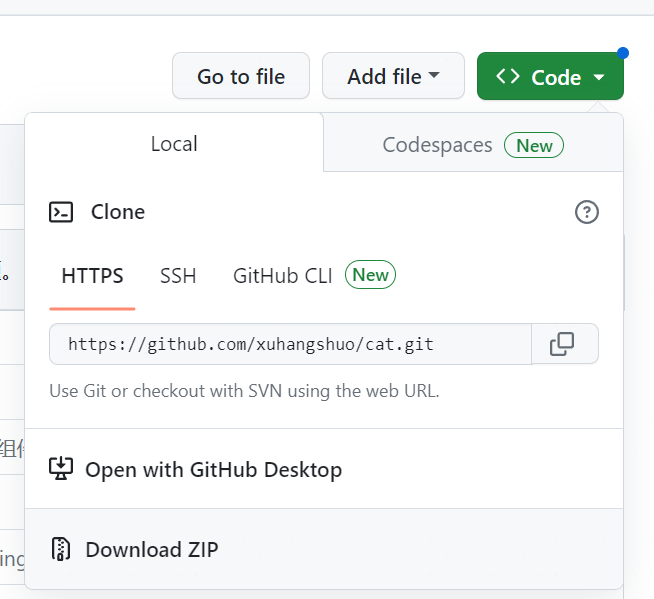

1.环境清单CentOS7 Java8 Maven3.5 MySQL5.7 CAT2.0.0 Tomcat7.02.安装CAT2.0下载CAT安装包:CAT的官方github地址:https://github.com/dianping/cat/tree/master打开页面之后,进行如下操作:2.1

1.环境清单CentOS7 Java8 Maven3.5 MySQL5.7 CAT2.0.0 Tomcat7.02.安装CAT2.0下载CAT安装包:CAT的官方github地址:https://github.com/dianping/cat/tree/master打开页面之后,进行如下操作:2.1 -

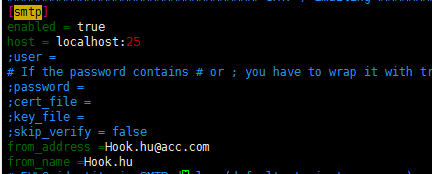

一.安装并启动sendmailyum install -y sendmail systemctl start sendmail二.修改Grafana配置文件,设置发件人vim /etc/grafana/grafana.ini在[smtp]标签下修改配置[smtp] enabled = true ho

一.安装并启动sendmailyum install -y sendmail systemctl start sendmail二.修改Grafana配置文件,设置发件人vim /etc/grafana/grafana.ini在[smtp]标签下修改配置[smtp] enabled = true ho -

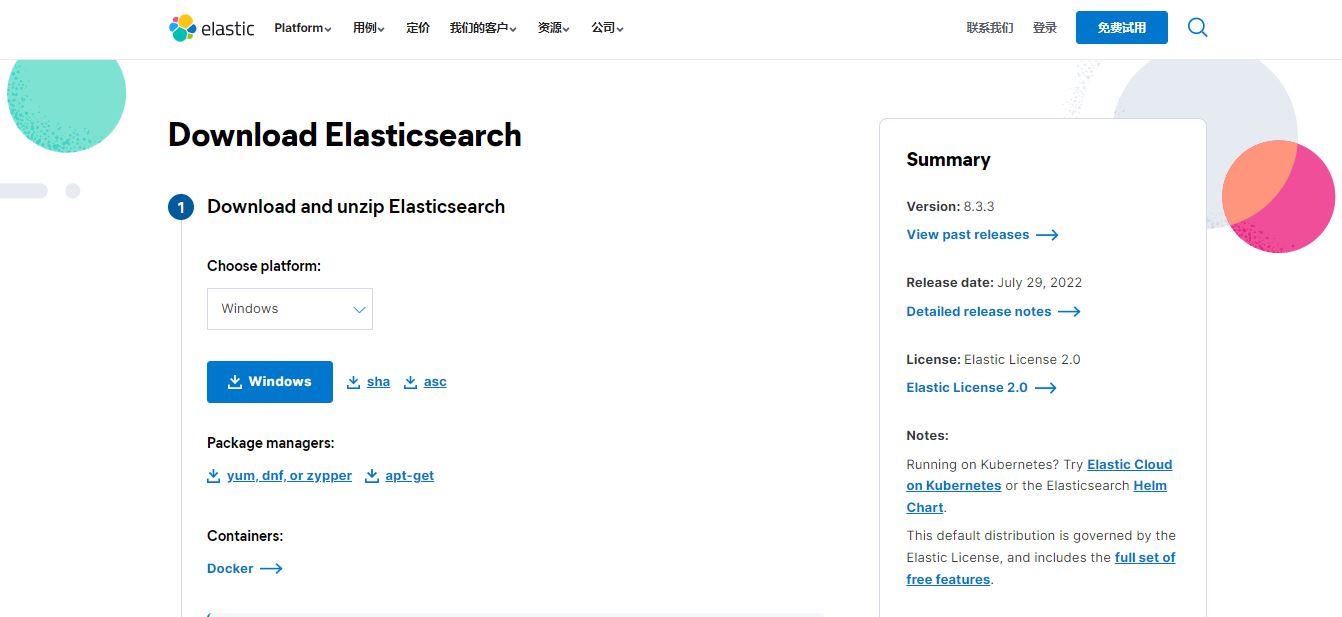

想用最简单的方式去理解Elasticsearch能为你做什么,那就是使用它了,让我们开始吧!安装并运行Elasticsearch安装Elasticsearch之前,你需要先安装一个较新的版本的Java,最好的选择是,你可以从www.java.com获得官方提供的最新版本的Java。之后,你可以从el

想用最简单的方式去理解Elasticsearch能为你做什么,那就是使用它了,让我们开始吧!安装并运行Elasticsearch安装Elasticsearch之前,你需要先安装一个较新的版本的Java,最好的选择是,你可以从www.java.com获得官方提供的最新版本的Java。之后,你可以从el -

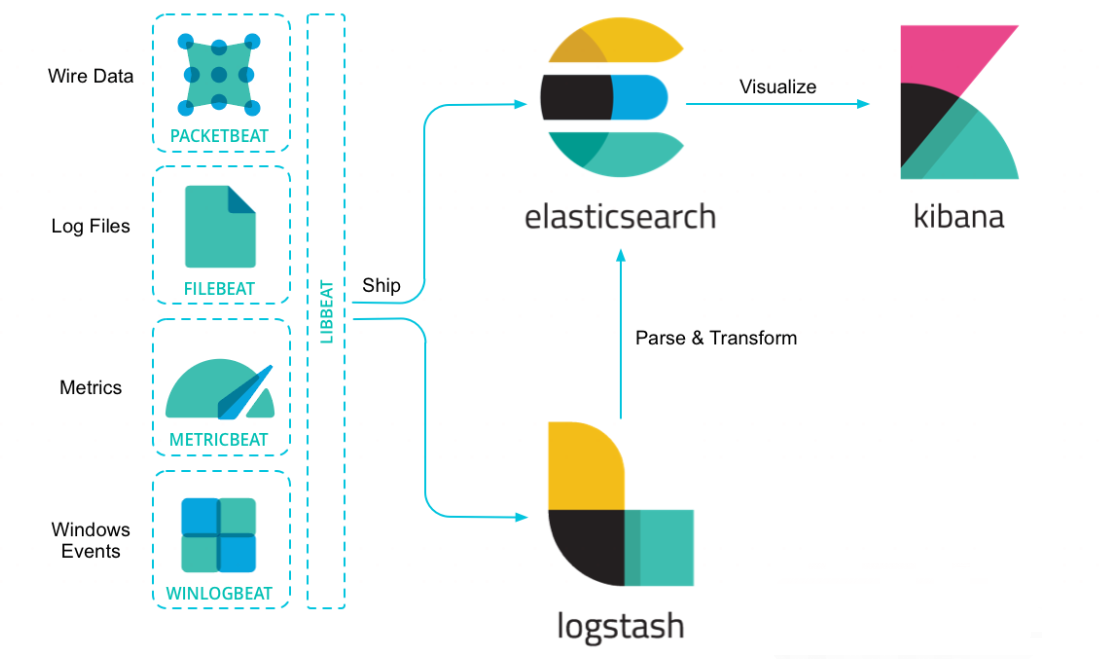

简介:Elasticsearch是一个分布式、RESTful风格的搜索和数据分析引擎,能够解决不断涌现出的各种用例。作为ElasticStack的核心,它集中存储您的数据,帮助您发现意料之中以及意料之外的情况。版本说明Java环境:JDK1.8.0Elasticsearch:7.2.1OS环境:wi

简介:Elasticsearch是一个分布式、RESTful风格的搜索和数据分析引擎,能够解决不断涌现出的各种用例。作为ElasticStack的核心,它集中存储您的数据,帮助您发现意料之中以及意料之外的情况。版本说明Java环境:JDK1.8.0Elasticsearch:7.2.1OS环境:wi